Page 22 -

P. 22

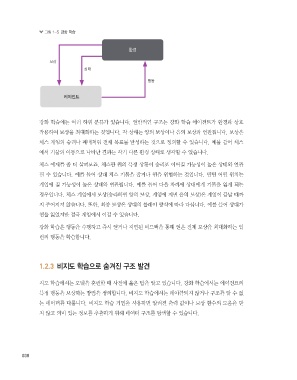

그림 1-5 강화 학습

환경

보상

상태

행동

에이전트

강화 학습에는 여러 하위 분류가 있습니다. 일반적인 구조는 강화 학습 에이전트가 환경과 상호

작용하여 보상을 최대화하는 것입니다. 각 상태는 양의 보상이나 음의 보상과 연관됩니다. 보상은

체스 게임의 승리나 패배처럼 전체 목표를 달성하는 것으로 정의할 수 있습니다. 예를 들어 체스

에서 기물의 이동으로 나타난 결과는 각기 다른 환경 상태로 생각할 수 있습니다.

체스 예제를 좀 더 살펴보죠. 체스판 위의 특정 상황이 승리로 이어질 가능성이 높은 상태와 연관

될 수 있습니다. 예를 들어 상대 체스 기물을 잡거나 퀸을 위협하는 것입니다. 반면 어떤 위치는

게임에 질 가능성이 높은 상태와 연관됩니다. 예를 들어 다음 차례에 상대에게 기물을 잃게 되는

경우입니다. 체스 게임에서 보상(승리하면 양의 보상, 게임에 지면 음의 보상)은 게임이 끝날 때까

지 주어지지 않습니다. 또한, 최종 보상은 상대의 플레이 방식에 따라 다릅니다. 예를 들어 상대가

퀸을 잃었지만 결국 게임에서 이길 수 있습니다.

강화 학습은 행동을 수행하고 즉시 얻거나 지연된 피드백을 통해 얻은 전체 보상을 최대화하는 일

련의 행동을 학습합니다.

1.2.3 비지도 학습으로 숨겨진 구조 발견

지도 학습에서는 모델을 훈련할 때 사전에 옳은 답을 알고 있습니다. 강화 학습에서는 에이전트의

특정 행동을 보상하는 방법을 정의합니다. 비지도 학습에서는 레이블되지 않거나 구조를 알 수 없

는 데이터를 다룹니다. 비지도 학습 기법을 사용하면 알려진 출력 값이나 보상 함수의 도움을 받

지 않고 의미 있는 정보를 추출하기 위해 데이터 구조를 탐색할 수 있습니다.

038

machinelearning_06.indd 38 2021-03-17 오후 12:36:05